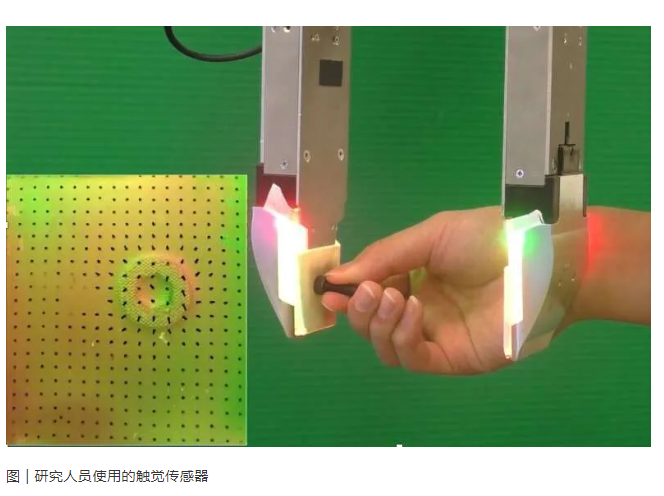

MIT研发可让机器人与周围环境进行交互的触觉传感器

人类能够通过触摸找到周围的物体并明确其某些属性,这一技能对盲人来说尤其重要,而没有视觉障碍的人同样在日常生活中频繁用到这一点,例如在口袋中摸索并抓住一样东西。

近日,麻省理工学院(MIT)的研究人员进行了一项技术研究,旨在将这种人类能力复制到机器人上,从而使其通过触摸即可了解对象的位置并可实时估计对象的姿态。该研究成果预先发表在 arXiv 上,论文着重强调了不再局限于视觉、音频处理而只需通过触摸就能与其周围的环境进行交互的机器人的优势。

“我们的研究目标是想证明,机器人通过高分辨率的触觉感应,甚至首次接触就可以准确定位已知的对象。与以前在触觉定位方面的工作相比,我们的方法有了重要的飞跃,因为我们不依赖于任何其他外部感应方式(例如视觉)或以前收集的与被操纵对象有关的触觉数据。恰恰相反,我们的技术是在模拟中直接训练的,它第一次触摸就可以定位已知对象,这在实际的机器人应用中至关重要,因为在真实的机器人中,实时数据收集成本很高或根本不可行。” 进行该项研究的研究人员之一 Maria Bauza 表示。

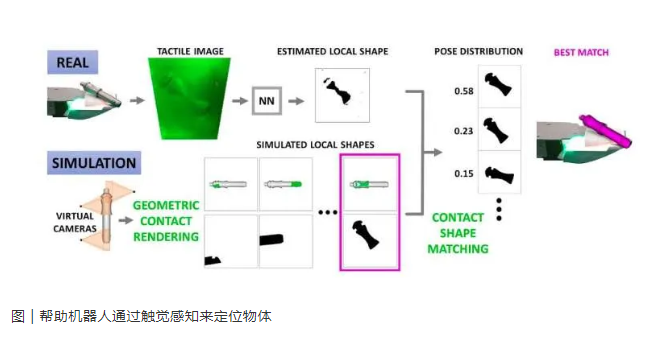

由于这项技术是在模拟中得到过训练,因此 Bauza 及其同事不再需要大量的数据收集。这些研究人员最初开发了一个框架,该框架可模拟给定对象与触觉传感器之间的接触,因此假设机器人有权访问与其交互的对象有关的数据(例如其 3D 形状、特性等)。这些接触会被描绘为深度图像,可显示出对象穿透触觉传感器的程度。

随后,他们使用先进的机器学习技术进行计算机视觉和表征学习,将机器人收集的真实触觉观察结果与模拟生成的一组接触信息进行匹配。根据模拟数据集中的每次接触与实际或观察到的接触的匹配可能性,对其进行加权,最终框架会获得对象的可能姿势的概率分布。

Bauza 说道:“我们的方法将被描绘为深度图像的接触编码到一个嵌入式空间中,这极大地简化了计算成本,可以做到实时执行。由于它可以产生有意义的姿势分布,因此可以轻松地与其他感知系统结合使用。例如,在多触点场景中,多个触觉传感器同时触摸一个对象,我们必须将所有的观察结果都整合到对象的姿态估计中。”

本质上,这种方法可以根据对象的 3D 形状模拟出接触信息。但他们发现,在利用这种技术仔细触摸对象时并不需要收集任何以前的触觉数据。也就是说,有了这项技术,机器人的触觉传感器可以在首次触摸到对象时就生成可能的姿势判断。

Bauza 表示,他们意识到触觉感知具有高度鉴别性,并能产生高度精确的姿势估计。“视力有时会受到遮挡的影响,但触觉感应却不会。因此,如果机器人触碰到了某个独特对象的一部分,且这种接触与其他的不同,那么我们的算法可以轻松识别出这一接触及对象的姿态。”

由于许多接触对象不具备的独特区域(即它们的放置方式可能导致最终的接触极其类似),因此 Bauza 及其同事开发的方法可以预测的是姿势分布,而不是单个姿势估计。这与此前开发的只收集单个姿势估计的对象姿态估计方法形成了鲜明的对比。而且,该框架预测的分布信息可以直接与外部信息进行合并,从而能够进一步减少对象姿态预测的不确定性。

值得注意的是,他们还观察到,同时使用多个手指接触对象,并同时对多个接触进行组合,也可以迅速减少对象姿态估计的不确定性。

图 | 技术概述:接触 -> 触觉观察 -> 触觉深度 -> 使用研发的算法进行最佳匹配 -> 产生姿势估计

参与这项研究的另一位研究员 Alberto Rodriguez 表示,“感应触摸能力最近在业界引起了极大了研究兴趣,而我们主要是通过结合三个因素来实现这一点的:(1)一种分辨率高但并不昂贵的感应技术,该技术使用小型相机来捕获触摸表面的变形(例如 GelSight 感应);(2)将此传感技术紧密结合到机器人手指(例如 GelSlim 手指)中;(3)基于深度学习的计算框架,来有效处理高分辨率触觉图像,从而通过已知零件完成触觉定位。”

总之,该研究小组设计的这项技术可以让机器人实时、高水平地估计其正在操作的对象的姿态,这样一来,就让机器人能够对其具体动作的影响做出更准确的预测,从而可以提高其在操作任务时的表现。这对工业当中根据物品形状的模型进行组装的制造商来说极具价值。

在未来的工作中,Bauza 团队计划扩展这一框架,使其能够涵盖有关对象的视觉信息。理想情况下,他们还希望将其技术转变为一种视觉 - 触觉传感系统,从而能够以更高的精度来估算对象的姿态。

“我们正在进行的另一项研究与这种方法密切相关,目的是探索触觉感知方法在复杂操作任务中的运用。现在我们正在学习能让机器人执行精确地抓放操作的模型,以实现稳定地抓握,帮助提高感知水平,改善触觉定位。” Bauza 表示。

登录

登录

注册

注册